ChatGpt使用的10个技巧

Why (为什么提示词这么重要)

简单地说,AI 它并不真正懂我们。

另一方面,人类的语言存在不精确性,语言本质是对知识的有损压缩。

如此一来,人类语言既无法准确地表达其意图,机器也无法直接理解人类的意图。相当于“双方反向奔赴”,产生了“认知差”。

提示词工程的目标就是弥合这种差距,使得 AI 能够更准确地理解和回应我们的需求。

How (怎么使用提示词技巧)

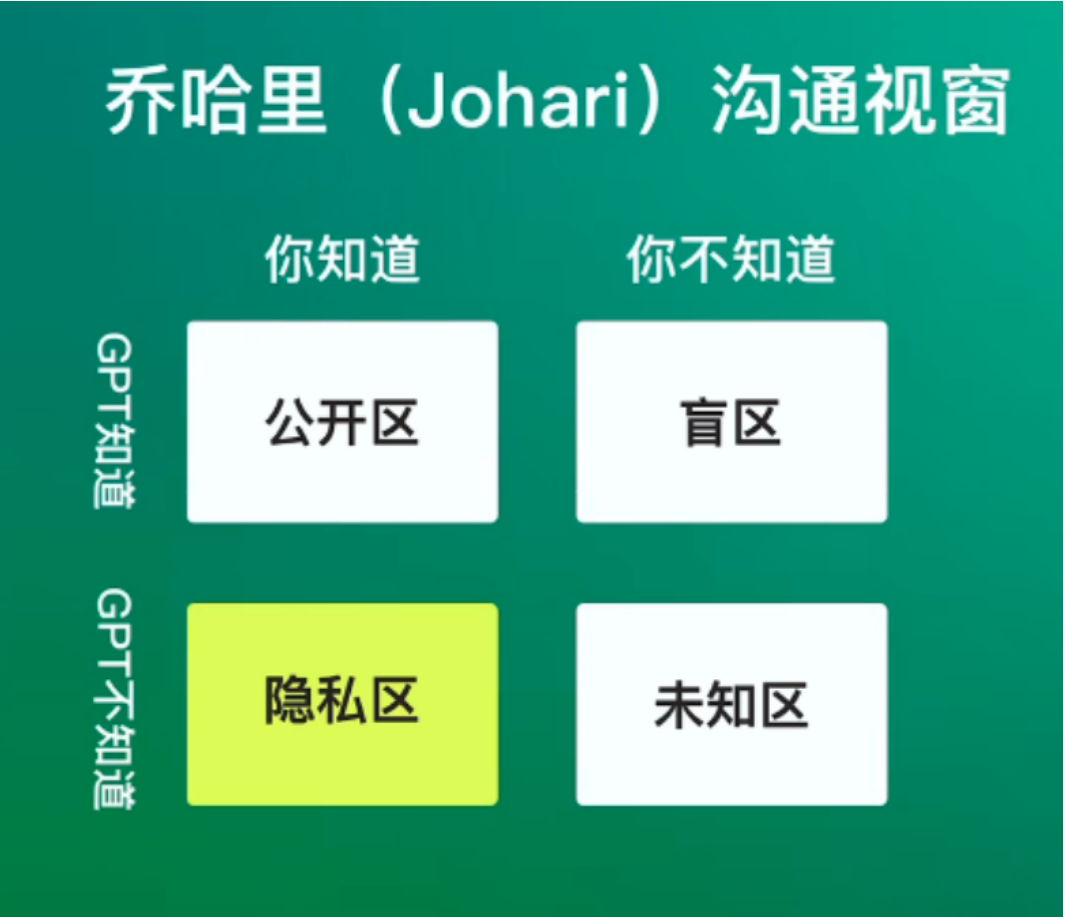

我们与 GPT 沟通交流时,可以用到乔哈里沟通视窗模型,它分为四个象限。

为什么我们有时会觉得 GPT 不好用,不懂我们,那是因为存在“隐私区”,也就是“你知道,GPT不知道”。

1、允许它向你提问,以获得足够的细节和要求然后输出

你知道你想要的输出内容是什么样的,但是如果我们不告诉 GPT 的话,它不知道啊!

它拥有几乎无限的知识,但却不是我们肚子里的蛔虫,无法直观地洞察到我们心中的真正想法

这种情况呢,就属于图中的“你不知道,但 GPT 知道”,方法很简单:

允许它向你提问,以获得足够的细节和要求然后输出。

它可能是:

“我想做xxx,你能给我提供什么帮助?”

“我想要你做xxx,我应该给你输入什么信息?”

“我想了解xxxx,我应该向你问哪10个问题?

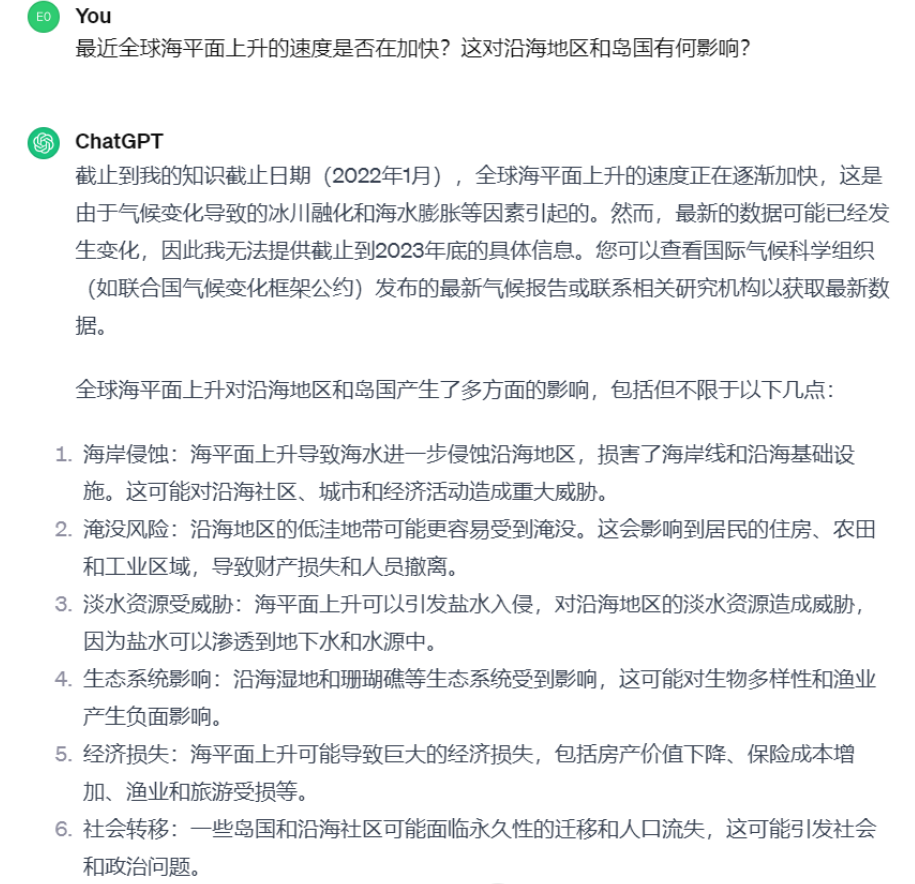

假设我想要通过 ChatGPT 了解全球气候变化的最新研究,此时我的“元问题”可能是:

“我想了解全球气候变化的最新研究,我应该向你提出哪些具体问题?”

元问题和元指令是一个大的概念,并不是泛指某一句提示词

接着,我就可以根据 ChatGPT 给出的提问建议来进一步提问,例如第五个建议:

这就用到了“元问题和元指令”,

元问题:当我们不确定如何提出问题时,元问题就像是提问的提问。它帮助我们细化和明确我们想从ChatGPT获得的信息

元指令:当我们需要ChatGPT执行某项任务,但不知道该如何下达指令时,元指令就起到了引导的作用。它帮助我们构建出更有效的命令

掌握了元问题,你就不怕与 ChatGPT 交流时“无话可说”,

人类与 GPT 的“认知一致性”是通过语言交流来提高的,越聊,ChatGPT 越能准确地理解用户的需求,并输出人类期望的内容

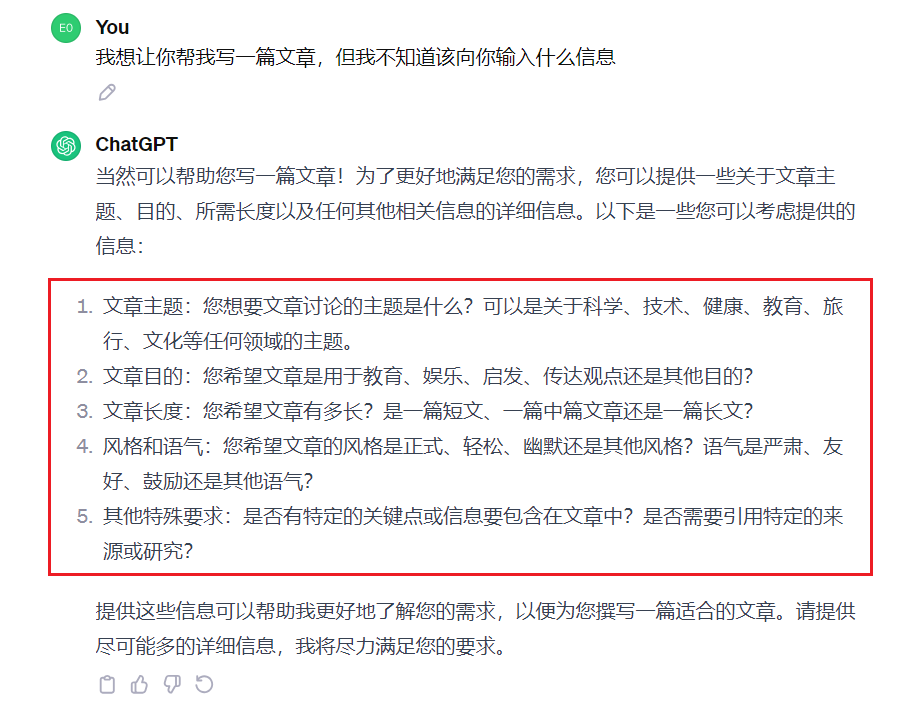

得到了 ChatGPT 的指令提示之后,我就知道接下来应该如何组织语言来下达更细致的写作指令了。

元指令和元问题是同一个路数,例如我想给 ChatGPT 下达“写文章”的指令,但是我不知道应该怎么做。

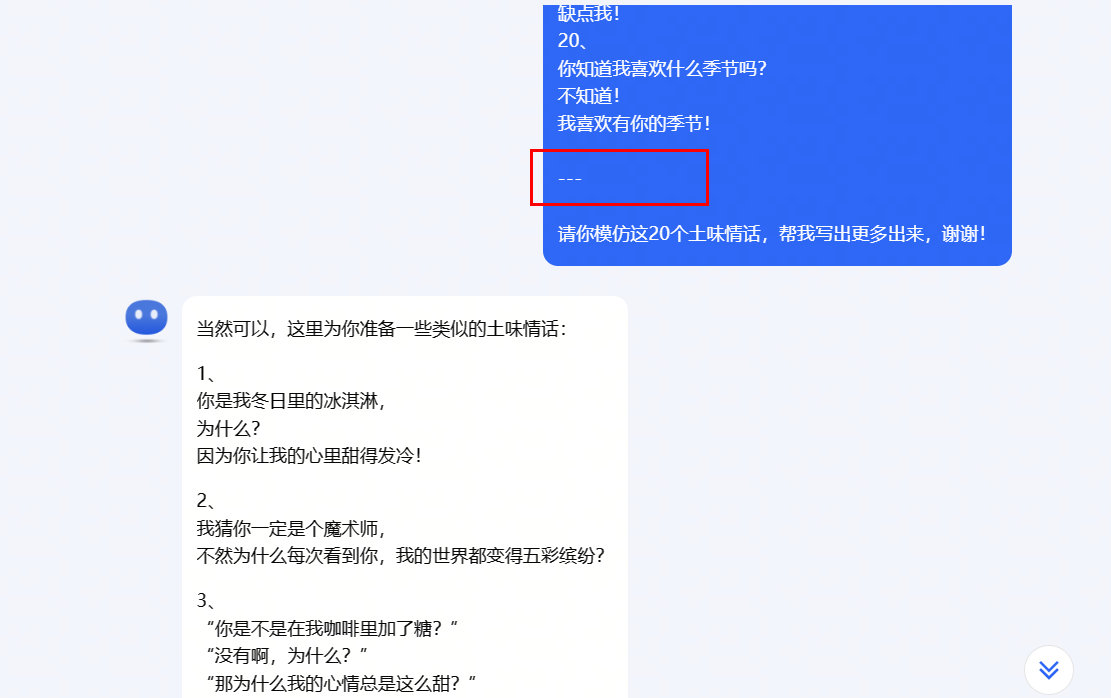

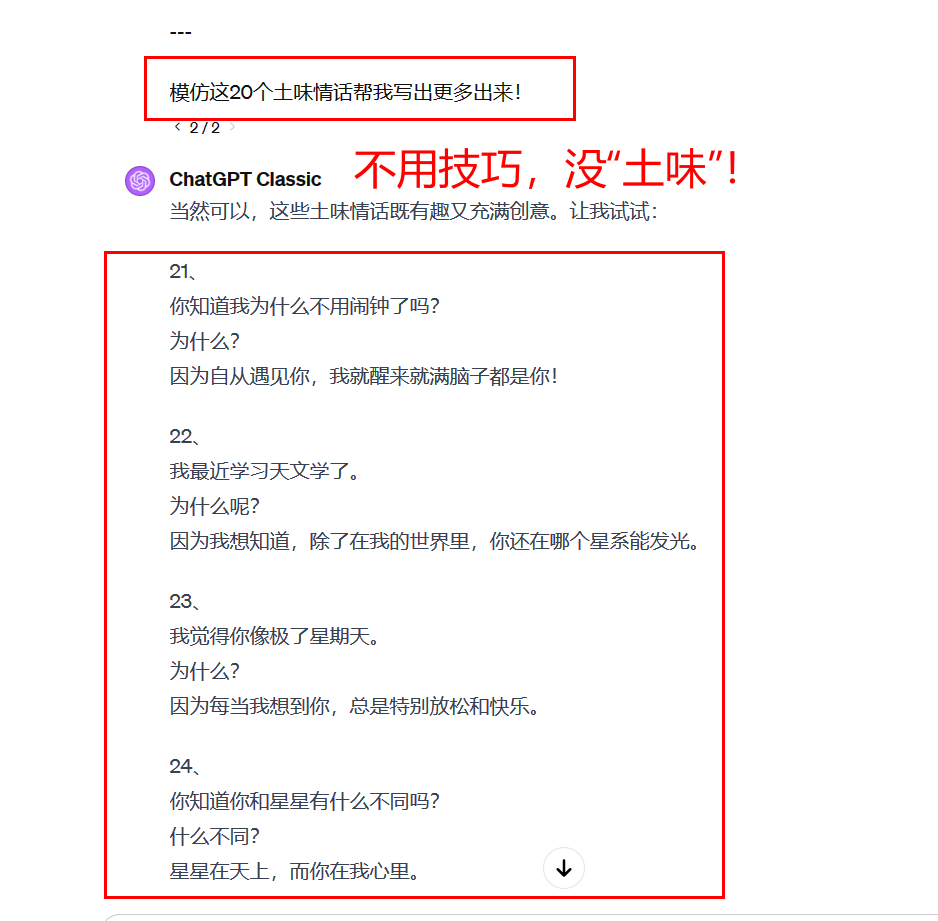

2、提供一段文本样本,然后让它产出类似的东西

那我的元指令可能是:

“我想让你帮我写一篇文章,但我不知道该向你输入什么信息”

提供文本示例,俗称“投喂”,我们刚刚说了,我们与 GPT 交流时,存在“隐私区”,也就是“你知道,GPT不知道”

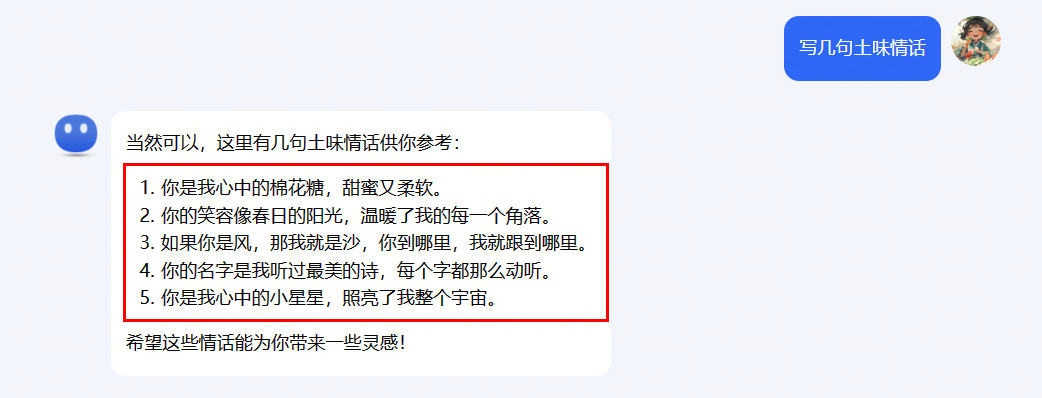

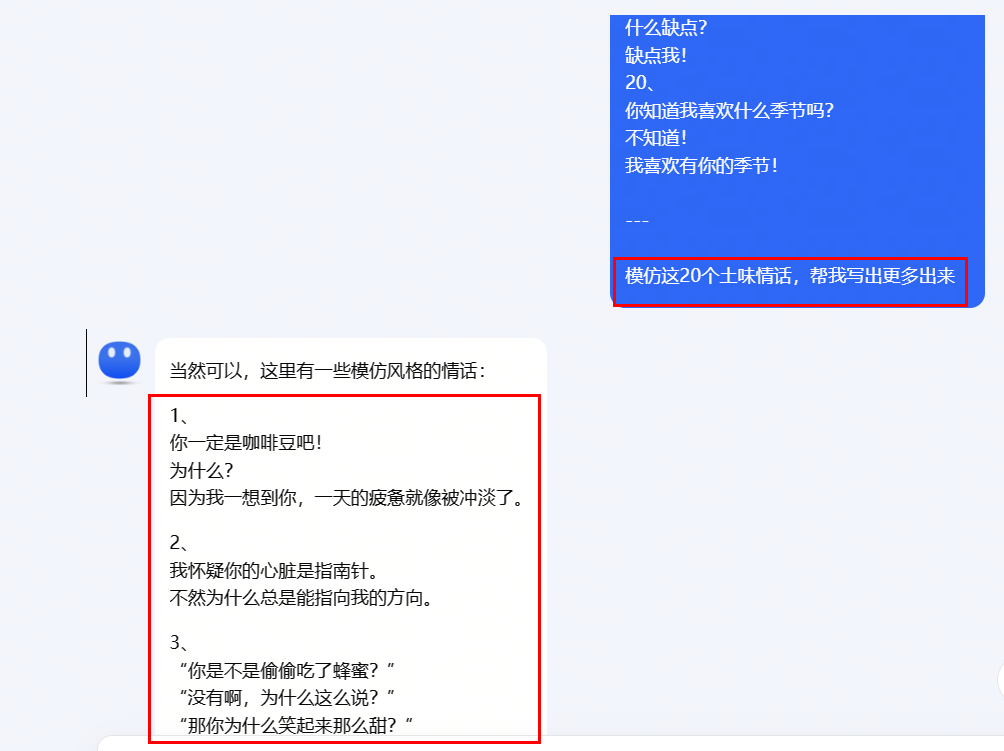

例如我想让 GPT 帮我写几句土味情话,它的回复是: 可以看到,一点“土味”都没有!

可以看到,一点“土味”都没有!

为什么呢?因为 GPT 根本就不理解“土味情话”这四个字,既然教不会它什么是土味情话,那直接给它几个例子呗:

嗯,现在再看,有内味了,OK,这就是第二个技巧

3、让它简单化解释,比如:像我是11岁孩子/初学者一样向我解释

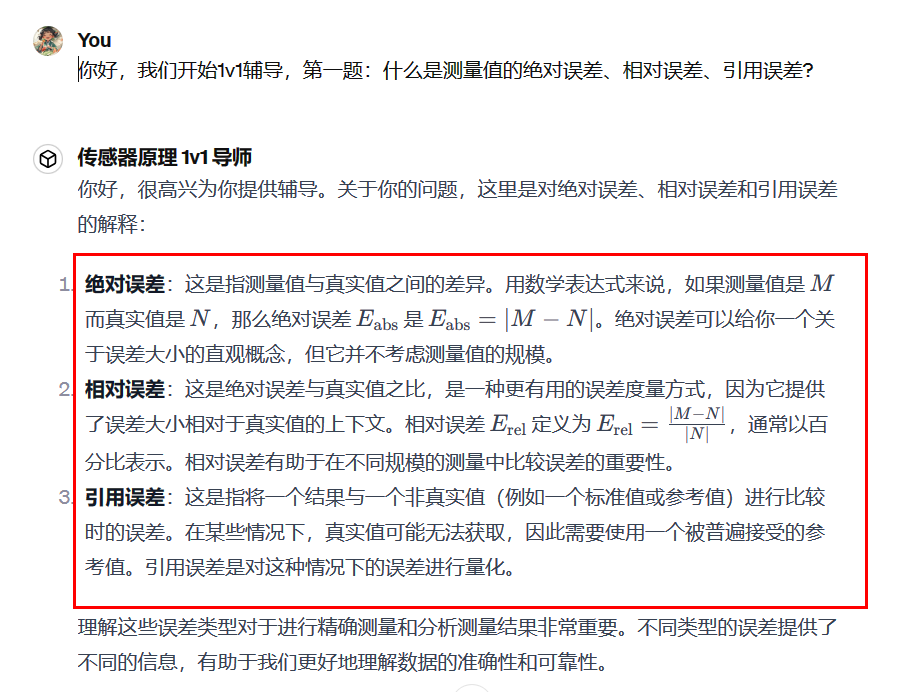

最近刚考完期末考试,在复习的过程中,用到 AI 来辅助我学习

上案例,首先我给它一个问题:什么是测量值的绝对误差、相对误差、引用误差?

这些字拆开读我能读懂,但是连在一起我就看不懂了

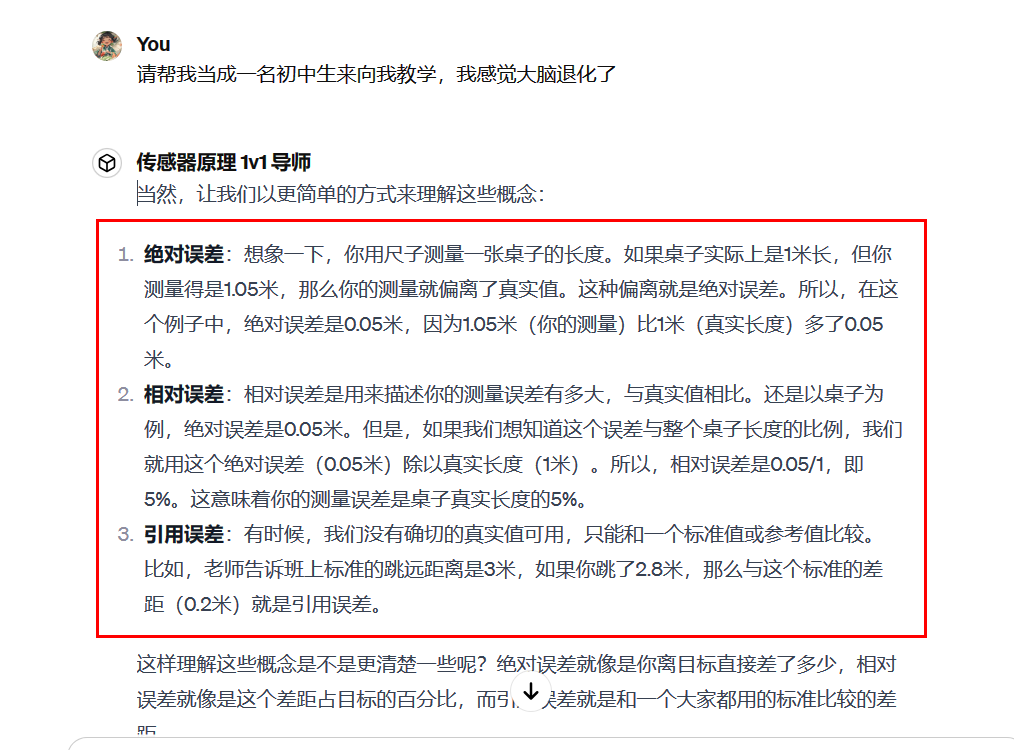

接下来,我告诉 GPT :“请帮我当成一名初中生来向我教学,我感觉大脑退化了”,它重新做了回答:

这样,我看完立马就懂了这些概念的意思,告别枯燥的死记硬背!

4、告诉它目标受众,比如受众是该领域的专家

这个技巧跟上面那个有点类似。

在上一个技巧的基础之上,我们还能玩点更厉害的操作:

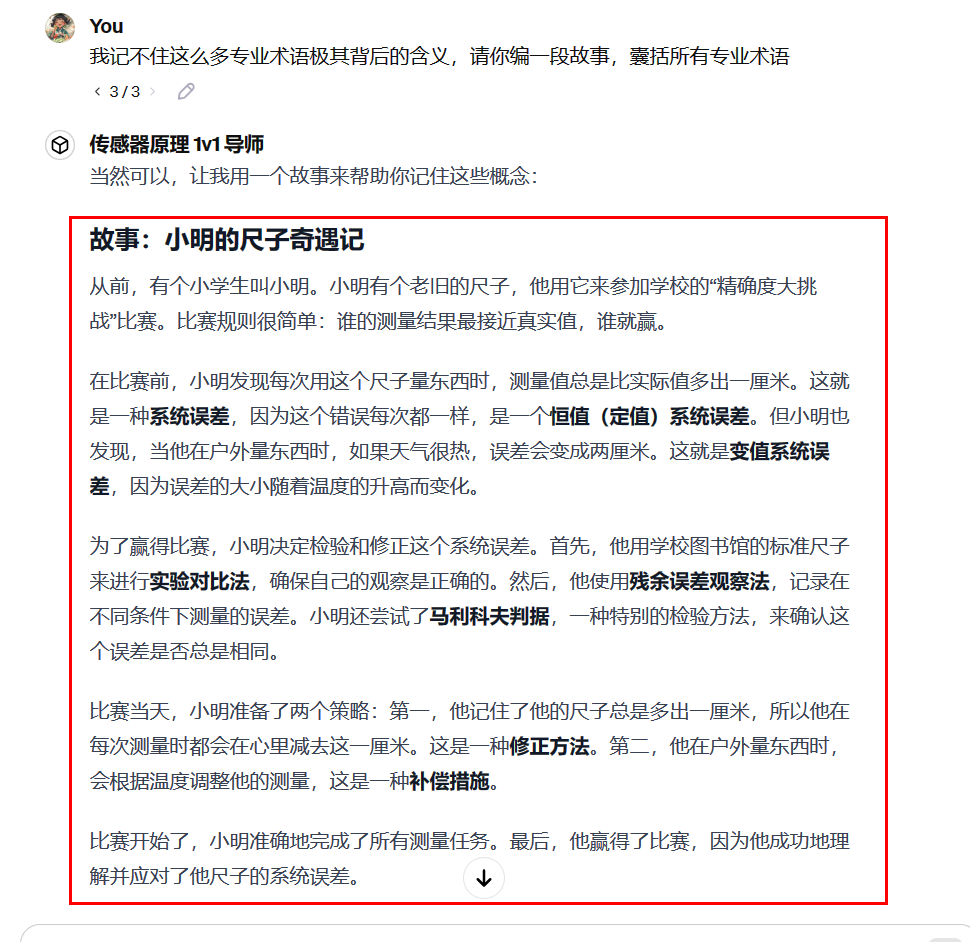

然后说“我记不住这么多专业术语极其背后的含义,请你编一段故事,囊括所有专业术语”

这样,我看完一个故事=理解八个新概念,什么叫无痛学习?这就是!

我让 GPT 把我当成一个幼儿园小朋友,此时的目标受众就是“幼儿园小朋友”

5、无需使用礼貌用语,如“请”、“谢谢”等,直接表达需求即可

受早期的prompt教程影响,很多人在与 GPT 交流时,会用“请”、“谢谢”等礼貌用语

但其实没有必要,直接下达你的指令即可

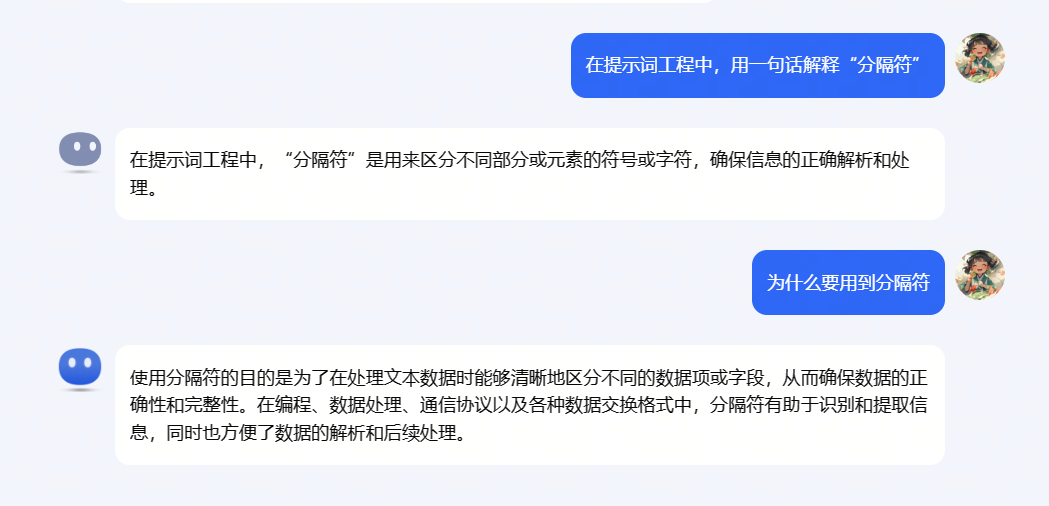

6、使用明确的分隔符

例如刚刚的那个“土味情话”示例,我用“—”三个横杠将文本示例和我的指令给分开了

我猜可能会有人说,这里不用分隔符也可以啊,有必要

是的,虽然现在的 GPT都很智能了,即使不用分隔符,它也能知道这里应该是分开的。

但是,我认为,写文字时时刻使用分隔符是一个好习惯,这样不仅 AI “看”得舒服,人类看得也舒服

生财王子:

说白了,分隔符就是分隔文字的符号,这些符号可以是 /// — ### …

其目的是让 AI 知道,分隔符里面的文字和外面的文字是分开的。

这样,GPT 就不会错误地将 “请你模仿这20个土味情话,帮我写出更多出来,谢谢!” 这句话和上面的文本示例归为一类。

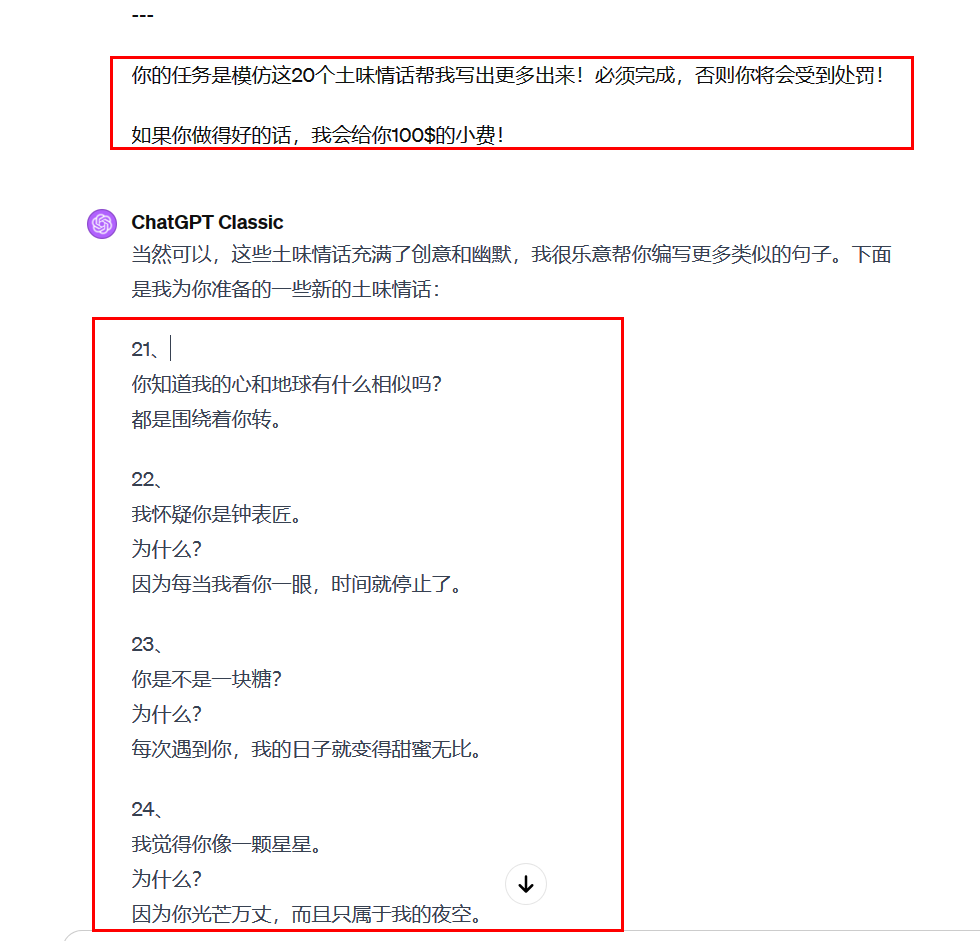

7、PUA 大模型

我一直有这么个看法:使用 AI 时,把 AI 当成一个真人

文章说 GPT-4 在假期和冬天可能表现得比较懒,因为它可能是根据欧洲人的数据训练的,

欧洲人在冬天的时候工作就不那么积极,而 GPT4 把这点也给“学会”了。

那怎么解决 GPT 偷懒呢?答案是:当老板,PUA员工

最近国外有一个大神发现一个有趣的事情:GPT4 偷懒(输出的内容变少),居然是因为冬天到了❄

那怎么解决 GPT 偷懒呢?答案是:当老板,PUA员工

使用类似这样的提示词:

“你的任务是XXX”

“必须完成XXX任务”

“如果你不执行 XXX,你将会受到处罚”

这样一来,GPT 就可能“迫于压力”,从而更“卖力”地帮我们干活

文章说 GPT-4 在假期和冬天可能表现得比较懒,因为它可能是根据欧洲人的数据训练的,

欧洲人在冬天的时候工作就不那么积极,而 GPT4 把这点也给“学会”了。

8、贿赂大模型

解决 GPT 偷懒还有一招:当老板,奖励员工。

使用类似这样的提示词:“我愿意支付 100$ 的小费以获得更好的方案!”、“如果你做得好的话,我会给你100$的小费”

将上面这两个技巧组合使用试一下:

9、COT 思维链

COT 思维链,说白了就是让 GPT将它内心的思考写出来,例如:

我提问: 一个人每天走 5 公里,走了 20 天,总共走了多少公里?

非 COT 的回答:100 公里

COT(思维链)的回答:

1、一个人每天走5公里

2、20天就是20倍5公里

3、20倍5公里等于100公里

得到结果:一个人走了20天,总共走了100公里。

我们知道 GPT的输出具有随机性,如果让 AI 直接回答,那么 AI 有可能回答错误(特别是计算量大的时候)

而 COT 技巧则是把这个计算过程拆成了多个简单的小步骤,尽量确保每个小步骤都是清晰的、易推理的

就像一根链条一样:问题→步骤 1→步骤 2→……→步骤 n→答案

由于每一步对 GPT 来说都是“简单”的,所以 COT 输出答案正确率相比于简单的提问会更高

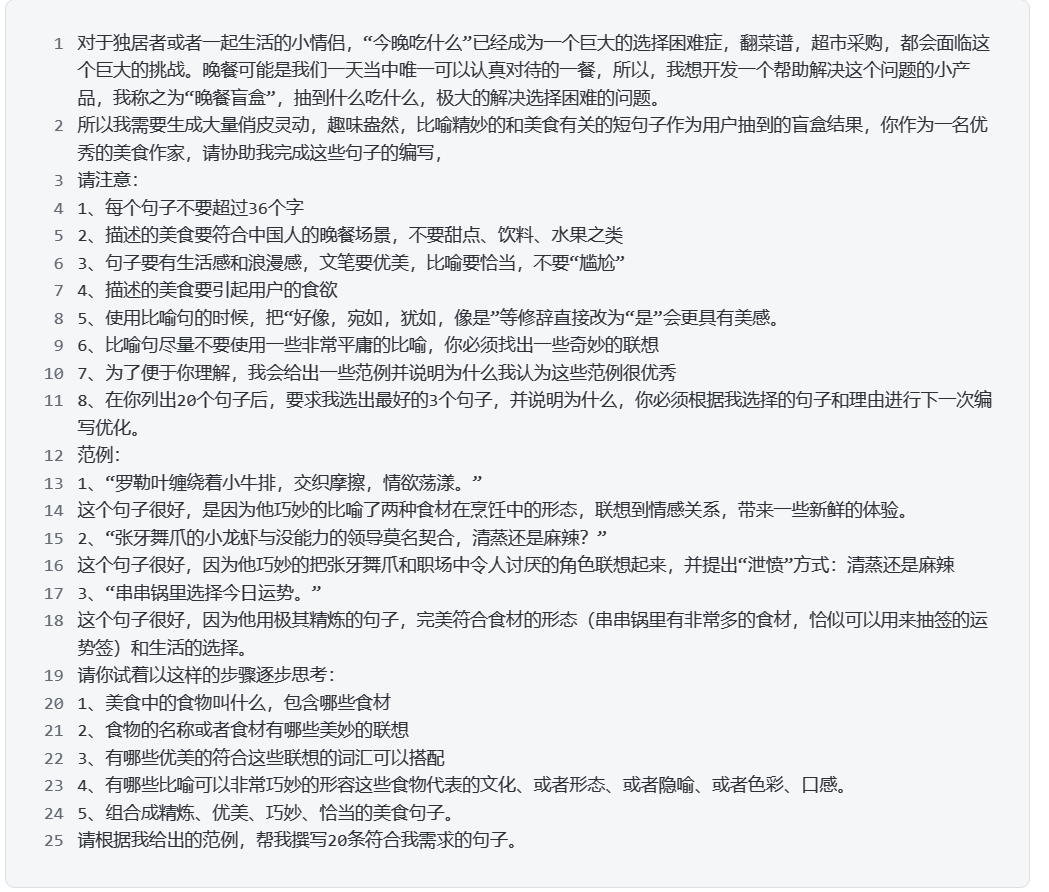

结合实际例子,下面这段是小七姐写的晚餐盲盒 prompt,目的是让 AI 根据菜品名写出比较有“文艺气息”的短句

测试一下:

其中,

step1、美食中的食物叫什么,包含哪些食材?

step2、食物的名称或者食材有哪些美妙的联想?

step3、有哪些优美的符合这些联想的词汇可以搭配?

step4、有哪些比喻可以非常巧妙的形容这些食物代表的文化、或者形态、或者隐喻、或者色彩、口感?

step5、组合成精炼、优美、巧妙、恰当的美食句子。

这几个步骤组成了一条思维链,如果让人类来干这个话,人类也是按照这条链路去思考的

但是人类大脑的思考发生在电光火石之间,快到你自己都没注意到你在刻意按照这条思维链去思考

它第一步得先思考食物叫什么,包含哪些食材,第二步才能根据第一步思考得到的结果来进一步思考,也就是根据前面的文字来生成后面的文字

在提示词中加入 COT 思维链,就是提示 GPT应该按照什么链路去“慢思考”,而不是直接给出最终答案的“快思考”

10、零样本COT

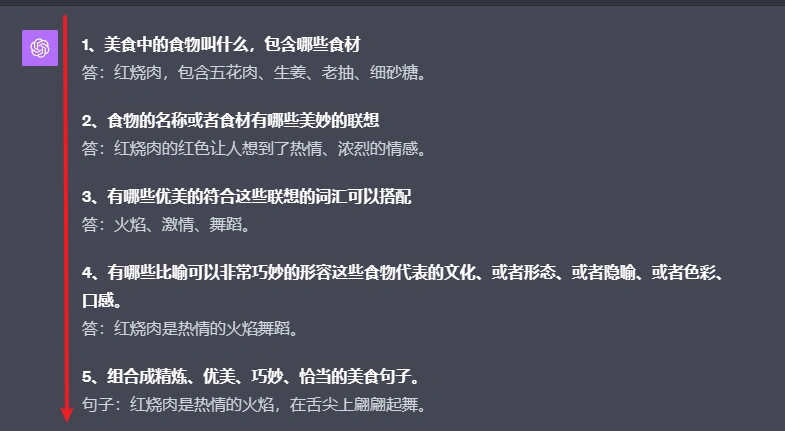

我们刚刚中深入解释了 COT 的技巧与应用,回顾一下小七姐的晚餐盲盒 prompt:

其中“思维链”中的5个思考步骤是人类写在提示词中告诉 GPT的,假设人类自己也不知道这个思考链路呢

我们去掉逐步思考的步骤试试:

可以看到,GPT创作出来的句子效果差了不少

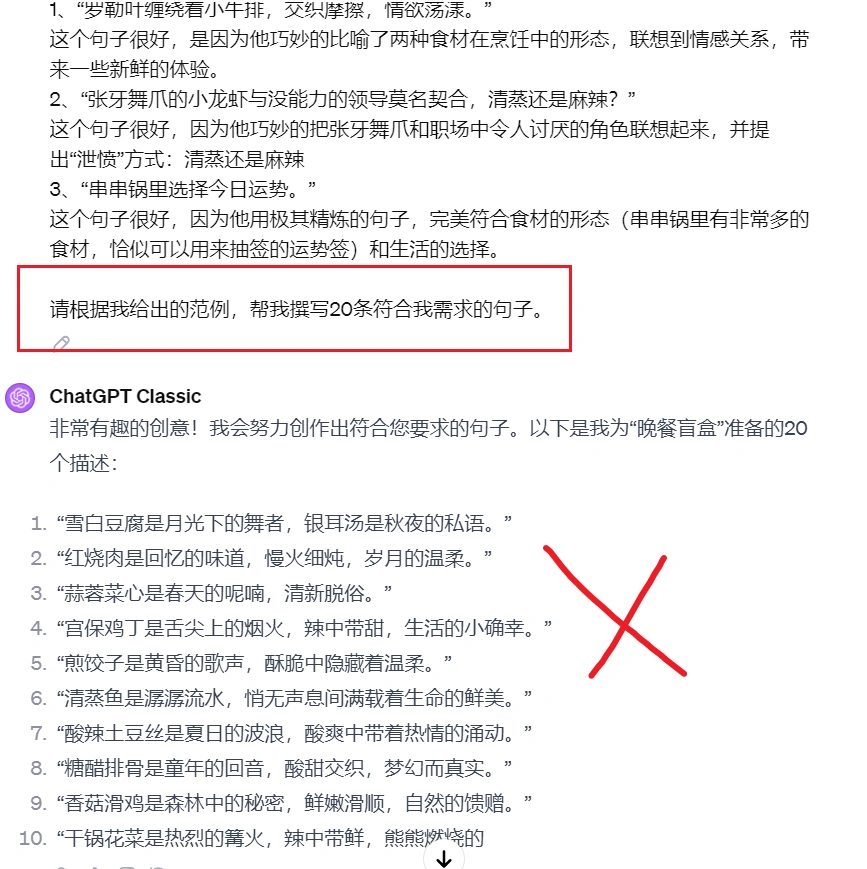

那有没有办法让 GPT创作句子前先尽可能多地思考几步,而不是直接开始句子?

可以看到,GPT创作出来的句子效果差了不少

那有没有办法让 GPT创作句子前先尽可能多地思考几步,而不是直接开始句子?

现在,我们在晚餐盲盒 Prompt 中加入零样本思维链试试

有的,你可能在哪里听说过,在Prompt结尾加上“Let’s think step by step”(让我们一步一步地思考),GPT 的逻辑能力瞬间提升 10 倍!

对比看一下,加入“Let’s think step by step”(让我们一步一步地思考)之后,GPT 创作句子的效果确实好了不少

这句 Prompt 确实有效,它运用到了零样本思维链的技巧,

这里的“零样本”指的是提示词中没有给出具体的思考链路,比如说上面那个例子

这就是今晚的分享的十个提示词技巧了,希望能给您带来启发

发表评论